Si tu lis cet article, c’est probablement que tu veux distinguer un texte humain d’un texte généré… sans y passer la journée.

Bonne nouvelle : Lucide AI est pensé pour ça, surtout en français.

Je l’utilise pour auditer des contenus avant publication, et je te montre exactement comment t’y prendre, quoi regarder, combien ça coûte et quand préférer une alternative.

D’abord, si tu explores des solutions, garde sous la main notre annuaire de tous les outils IA.

Pourquoi choisir Lucide AI plutôt qu’un autre détecteur ?

Tu veux un détecteur IA fiable en français. C’est là que Lucide AI marque des points : l’outil met en avant sa spécialisation francophone, gère les documents longs (PDF, Word, OpenOffice) et renvoie un score facile à interpréter. Ça paraît basique, mais dans la pratique, c’est ce qui te fait gagner du temps.

Concrètement, Lucide contrôle des textes potentiellement générés par ChatGPT, Google Gemini, Mistral AI ou Claude. Si tu bosses avec des rédacteurs, des étudiants ou une équipe éditoriale, c’est rassurant d’avoir un outil qui parle la langue et le contexte.

Quand je le recommande :

- Tu publies en français (SEO, blog, presse).

- Tu dois auditer des documents longs sans copier-coller tout le contenu.

- Tu veux une API simple pour automatiser les contrôles.

Quelles fonctionnalités comptent vraiment ?

Détection de contenu IA : quoi regarder dans le rapport

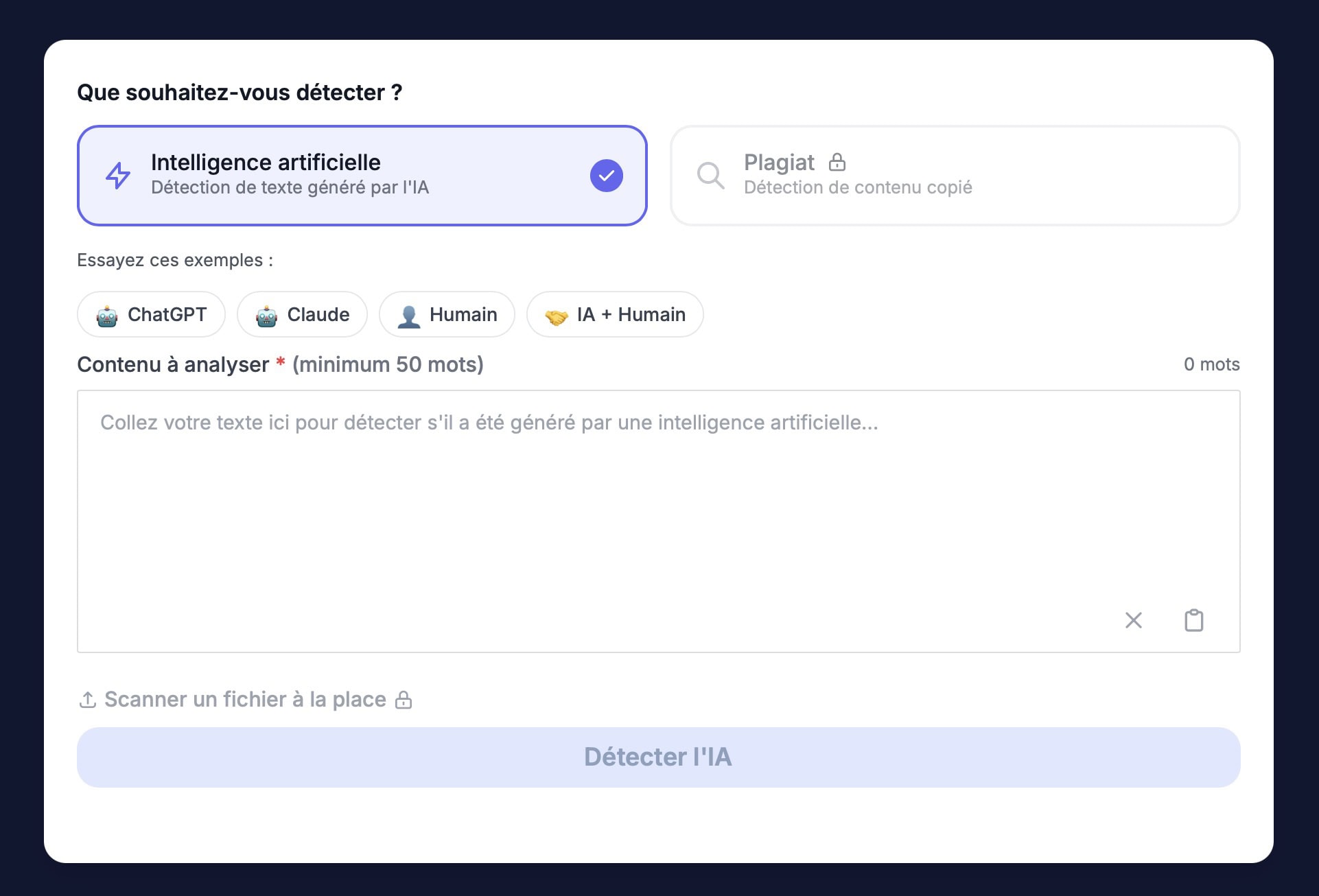

Tu colles un texte (ou tu importes un PDF/Doc), tu lances l’analyse, et tu obtiens un score. C’est ce score que tu vas confronter à ta connaissance du texte (brief, style, sources). Lucide gère les formats bureautiques courants, donc pas besoin de tout convertir. Pratique.

Astuce de lecture :

- Score élevé → suspicion d’IA. Relis les passages “plats” (syntaxe trop lisse, répétitions, enchaînements mécaniques).

- Score ambigu → complète l’analyse : longueur du texte, sources citées, cohérence des exemples.

- Score faible → ne t’arrête pas là : un texte humain peut être paraphrasé par une IA.

API & intégrations : automatiser sans douleur

Tu peux connecter l’outil à ton workflow (publication, QA, CRM éditorial…) via API pour lancer des analyses dès qu’un brouillon passe en “à relire”. Idéal si tu traites beaucoup d’articles.

Comment je l’utilise pas à pas (tuto express)

L’objectif : un process rapide et répétable.

- Préparer

- Rassemble 2–3 textes de référence de l’auteur (échantillons humains).

- Fixe une taille minimale (≥ 300–500 mots) pour éviter les illusions sur textes trop courts.

- Analyser

- Importer le fichier (PDF/Doc) ou coller le texte.

- Lancer l’analyse et noter le score + les passages suspects.

- Recouper

- Compare au style de l’auteur.

- Pose 2–3 questions sur le raisonnement (pourquoi ce plan ? pourquoi cette source ?).

- Si c’est ambigu, rééchantillonne : retire les citations, demande un exemple concret.

- Décider

- Score très élevé + incohérences → demande une réécriture (humain, preuves, sources).

- Mélange humain/IA → exige des sources + reformulation personnalisée.

- Ok → publie… mais garde une trace (rapport + commentaires).

Important : aucun détecteur n’est infaillible. OpenAI a d’ailleurs abandonné son “AI Text Classifier” pour faible précision — utile à garder en tête quand tu interprètes un score.

Précision, limites… et comment éviter les pièges

Tu l’as deviné : aucun détecteur n’est magique. Des retours récents montrent des faux positifs et des biais possibles (par ex. sur certains profils de rédacteurs). Bref, le signal est informatif, pas un verdict. Pour cadrer l’approche, je te conseille de t’appuyer aussi sur des repères “normés” : les travaux du NIST expliquent bien ce que la détection de contenu synthétique peut (et ne peut pas) faire, et distinguent la détection de la provenance (métadonnées, filigranes).

Ma checklist “anti-erreurs” :

- Échantillonner au-delà de 300–500 mots quand c’est possible.

- Retirer les citations et éléments formatés (code, tableaux) avant test.

- Poser des questions de compréhension à l’auteur (justifications, angles, exemples).

- Tracer la décision finale (notes + annexes).

- Croiser avec une solution tierce quand l’enjeu est élevé (publication sensible, dossier étudiant, client grand compte). Pour creuser les limites et biais des détecteurs en contexte éditorial, lis ce décryptage de WIRED.

Combien ça coûte ? Mon point sur le ROI

Les formules restent abordables et adaptées à la volumétrie (indépendant, équipe, école). Mon conseil : commence petit, mesure le nombre réel d’analyses sur un mois, ajuste ensuite.

Le vrai coût, c’est une erreur de jugement (perte de crédibilité, friction client, correction tardive).

Mieux vaut un contrôle simple et systématique qu’un grand ménage après coup.

Lucide AI vs Originality.ai vs Winston AI : que choisir selon ton cas ?

Je te donne mes raccourcis d’arbitrage. Ils marchent bien en agence et en milieu académique.

- Tu publies surtout en français et tu veux un process simple (fichiers bureautiques, score clair) → Lucide AI.

- Tu bosses en multilingue et tu veux un écosystème complet (plagiat, QA, lectures groupées) → Originality.ai.

- Tu veux un contrôle “au mot” (texte long, granularité, plagiat et image) → Winston AI.

Astuce pro : Sur un même échantillon, fais 2 passes (Lucide + une alternative) avant un livrable sensible.

Tu obtiens un jugement croisé et tu sécurises la décision finale. Et oui, c’est ce que je fais pour les audits délicats.

Cas d’usage concrets (tu peux les copier-coller dans ton process)

- Agence SEO : avant livraison, tu scans l’article final + la version “brief”. Si le score est ambigu, tu exiges des sources et 2 paragraphes d’exemples au style de la marque.

- École / formation : tu demandes un journal de bord (recherches, brouillons) + entretien oral court si doute. Le détecteur n’est qu’un indicateur, jamais un verdict automatique.

- Rédac / médias : sur sujets sensibles, tu croises détection + vérification de faits + appel à la source. (Oui, même un texte humain peut être bâclé.)

Le récap

- Lucide AI est un détecteur IA tourné vers le français, pratique pour auditer des documents longs, avec une API si tu veux automatiser.

- Aucun détecteur n’est infaillible : utilise un process (échantillonnage, recoupements, questions à l’auteur).

- ROI : commence modeste, mesure l’usage, et scale si ça te fait gagner du temps.

Hop, à toi de jouer : prends un article en cours, scanne-le avec Lucide, recoupe avec une alternative… et dis-moi ce que tu observes. Je parie que tu vas repérer des signaux que tu n’avais jamais vus.